Subtotal 0,00 €

Índice

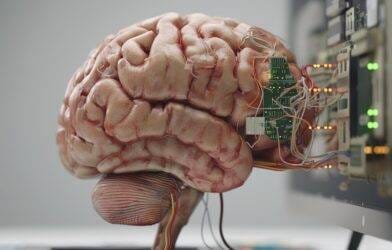

Imagina esto: le muestras a una inteligencia artificial de última generación la foto de un adorable panda. Pero la IA, con toda su potencia computacional, te dice que es… un avestruz. ¿Magia negra? ¿Un bug tonto? No, es algo más sutil y preocupante: un ataque adversario. Bienvenidos al lado oscuro del machine learning, donde pequeñas alteraciones, invisibles para nosotros, pueden hacer que nuestros brillantes algoritmos se comporten de forma errática y peligrosa. Estos ataques adversarios IA: ¿la criptonita del machine learning? Analicemos esta creciente amenaza que pone en jaque la confianza en la inteligencia artificial.

El Arte del Engaño Digital: ¿Qué Son Exactamente los Ataques Adversarios?

Olvídate del hacking tradicional con malware y brechas de seguridad aparatosas. Los ataques adversarios son más bien una forma de “judo” digital. No rompen el sistema, lo manipulan desde dentro aprovechando su propia lógica. Como señala Rubén García Ramiro, experto en ciberseguridad consultado en la fuente original, se trata de “intentar engañar a la inteligencia artificial basándose en imágenes, audio o similar” mediante una “mínima modificación”.

En esencia, un atacante introduce cambios minúsculos y calculados matemáticamente en los datos de entrada (una imagen, un archivo de audio, un texto). Para un humano, la foto sigue siendo un panda, la voz sigue sonando igual. Pero para el modelo de IA, entrenado para detectar patrones específicos, ese “ruido” estratégicamente añadido lo descarrila por completo. Lo confunde, llevándolo a clasificar erróneamente (panda -> avestruz) o, peor aún, a tomar decisiones incorrectas. Es una manipulación matemática IA deliberada que explota cómo aprenden estos sistemas.

¿Por Qué Debería Importarte si una IA Confunde un Panda? Las Consecuencias Reales

Que una IA no sepa distinguir un oso de un pájaro gigante puede parecer anecdótico, pero las implicaciones de los ataques adversarios van mucho más allá. Piensa en sistemas que ya usamos o usaremos pronto:

- Reconocimiento Facial: Un atacante podría usar gafas con un patrón específico o maquillaje diseñado para evadir la detección o incluso hacerse pasar por otra persona (suplantación de identidad). ¿Privacidad bienvenida o puerta abierta al crimen?

- Vehículos Autónomos: Este es el ejemplo estrella del pánico. Imagina pegatinas estratégicamente colocadas en una señal de STOP. Para ti, sigue siendo un STOP. Para la IA del coche, podría interpretarse como un límite de velocidad de 100 km/h. Las consecuencias son potencialmente catastróficas. La seguridad de los vehículos autónomos depende críticamente de la fiabilidad de su percepción.

- Filtros de Spam y Moderación de Contenido: Los atacantes pueden modificar ligeramente mensajes maliciosos para saltarse los filtros automáticos.

- Diagnóstico Médico: Aunque aún en desarrollo, si las IA ayudan a analizar imágenes médicas, una manipulación podría llevar a diagnósticos erróneos.

- Sistemas Financieros: Manipular datos de entrada podría alterar predicciones de mercado o decisiones automatizadas de trading.

El abanico de posibilidades es tan amplio como la implementación de la IA en nuestras vidas.

La Asimetría Incómoda: Atacar es Fácil, Defenderse una Pesadilla (Cara)

Aquí reside uno de los mayores problemas de la ciberseguridad IA: existe una preocupante asimetría entre ataque y defensa.

- Atacar es (relativamente) barato y fácil: Como explica García Ramiro, a menudo es un proceso de “prueba y error”, generando “el menor ruido posible” hasta dar con la vulnerabilidad. No siempre se necesita un conocimiento profundo del modelo exacto (gracias a la “transferibilidad” de los ataques entre modelos similares). Peor aún, según el experto, “cualquier persona con mínimos conocimientos puede hacerlo”, ya que existen “repositorios con toda la información necesaria, incluso programas ya publicados”. Herramientas como CleverHans, una librería de código abierto para benchmarking de defensas, paradójicamente, también pueden ayudar a entender cómo construir ataques.

- Defenderse es caro y complejo: Proteger un modelo requiere mucho más esfuerzo. Implica verificar constantemente posibles vulnerabilidades, implementar múltiples capas de defensa, realizar un monitoreo exhaustivo y, crucialmente, reentrenar los modelos, lo que consume enormes recursos computacionales. “Defenderse […] genera mucho más esfuerzo computacional, lo que genera un gran coste que se suma al de la inteligencia artificial, que ya de por si es caro”, sentencia García Ramiro. Las empresas deben realizar inversiones millonarias para una protección robusta.

Esta disparidad es un dolor de cabeza constante para quienes desarrollan e implementan sistemas de IA.

Defendiendo al Algoritmo: ¿Hay Esperanza Contra la Criptonita de la IA?

A pesar del panorama algo sombrío, no todo está perdido. La comunidad científica y de ciberseguridad trabaja activamente en defensas contra estos ataques.

Entrenamiento Adversario: Luchar Fuego con Fuego (Controlado)

Una de las técnicas más prometedoras es el entrenamiento adversario. Consiste, básicamente, en “vacunar” al modelo. Durante el entrenamiento, se le exponen ejemplos adversarios generados artificialmente. Al aprender a identificar y clasificar correctamente estas entradas manipuladas, el modelo se vuelve más robusto contra ataques similares en el futuro. Es como enseñarle al sistema a reconocer los trucos del enemigo.

Detección y Robustecimiento: Capas Extra de Seguridad

Otras estrategias incluyen:

- Detección de Anomalías: Implementar sistemas que detecten si una entrada parece sospechosamente manipulada.

- Procesamiento de Entrada: Modificar o “sanitizar” las entradas antes de que lleguen al modelo principal para eliminar posibles perturbaciones adversarias.

- Modelos más Robustos: Investigar arquitecturas de redes neuronales que sean intrínsecamente menos susceptibles a estas manipulaciones.

¿Usar el “Veneno” como “Antídoto”?

Curiosamente, las técnicas adversarias también podrían usarse para bien. García Ramiro sugiere un escenario futuro donde se genere “ruido” controlado (un ataque adversario benigno) para proteger información sensible. Por ejemplo, añadir un sutil ruido a una videoconferencia para impedir que una IA maliciosa pueda clonar la voz de los participantes. Una idea intrigante que explora el doble filo de esta tecnología.

El Futuro Incierto: ¿Confiaremos en una IA “Engañable”?

Los ataques adversarios IA plantean preguntas fundamentales sobre la fiabilidad y seguridad de la inteligencia artificial. Como apunta García Ramiro, muchas empresas aún están más enfocadas en desarrollar capacidades que en blindar sus modelos, aunque espera que esto cambie pronto.

A medida que la IA se integra más en infraestructuras críticas, sistemas financieros, transporte y defensa, la necesidad de abordar estas vulnerabilidades se vuelve imperativa. La confianza pública en la IA dependerá, en gran medida, de nuestra capacidad para asegurar que no sea fácilmente “engañable”. ¿Estamos preparados para la carrera armamentística entre los creadores de IA y quienes buscan explotar sus debilidades? Es una pregunta abierta y crucial para el futuro tecnológico.

Conclusión: Vigilancia Constante en la Era del Algoritmo

Los ataques adversarios no son una simple curiosidad académica; son una amenaza real y creciente para la seguridad y fiabilidad de los sistemas de inteligencia artificial. Demuestran que incluso los algoritmos más avanzados pueden tener puntos ciegos explotables. Sí, podríamos estar ante ataques adversarios IA: ¿la criptonita del machine learning?

La defensa requiere un esfuerzo continuo, costoso y multifacético, desde el entrenamiento adversario hasta el desarrollo de arquitecturas más robustas. La ingenuidad de hoy puede ser la vulnerabilidad crítica de mañana. Mientras la IA sigue evolucionando, la vigilancia y la inversión en ciberseguridad IA no son opcionales, son esenciales si queremos construir un futuro donde podamos confiar en las máquinas que cada vez toman decisiones más importantes por nosotros. Puedes seguir informado sobre los últimos avances y desafíos en IA en nuestra sección de Noticias o profundizar tus conocimientos en el área de Formación.